科学研究

北理工威廉希尔许廷发教授团队在机器视觉分类中噪声和长尾数据处理方面取得新进展

近日,英国威廉希尔公司许廷发科研团队在机器视觉分类中噪声和长尾数据处理方面取得新进展,相关研究成果以“Delving into Sample Loss Curve to Embrace Noisy and Imbalanced Data”为题被人工智能领域的国际顶级会议AAAI-2022 (CCF A)发表,AAAI是人工智能领域具有高影响力的国际顶级学术会议之一,被计算机协会归类为A类会议,主要发表和报道计算智能、人工智能、数据科学和深度学习等领域的最新研究进展和技术。该工作第一作者为北京理工大学博士后江慎旺,通讯作者为北京理工大学李佳男特别副研究员和许廷发教授。

随着人工智能的发展,如何在噪声和长尾数据中训练模型在机器学习中引起了很多关注。然而,当前大多数方法都在理想化的状态下研究如何单独处理噪声或者长尾数据的问题,针对这一科学问题,北京理工大学许廷发教授团队率先提出损失值曲线和元学习的方法同时解决噪声和长尾数据,通过大量的计算和实验观察发现,虽然从单个的权重无法区分噪声和尾部样本,但是在样本的整个训练过程生成的损失值曲线能够提供充足的信息区分这两种样本,如图1。

图1损失值曲线

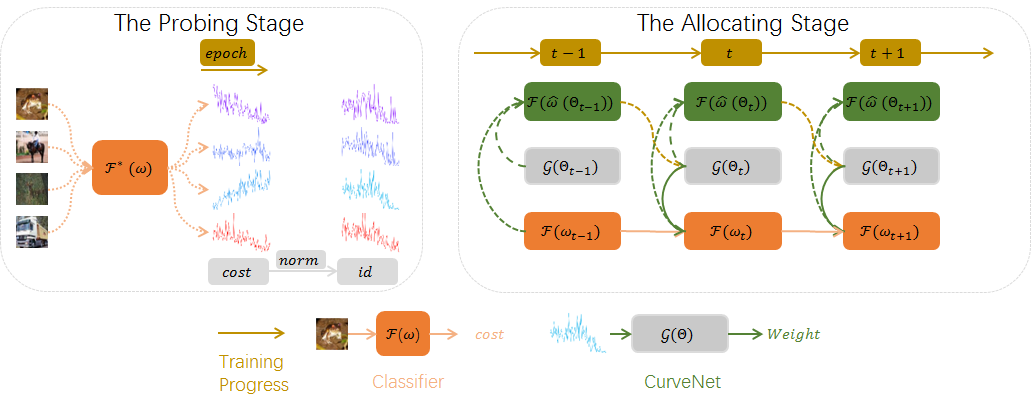

在此基础上,科研团队提出了损失值曲线的噪声和长尾数据处理模型。如图2,基于损失值曲线的噪声和长尾数据处理模型可以被分为两个阶段: Probing Stage和Allocating Stage。在Probing Stage先训练一遍模型,得到每个样本的损失值曲线;在Allocating Stage将损失值曲线作为样本的一项特征输入至权重生成模型并为每个样本生成权重,采用元学习方法进行了优化。

图2基于损失值曲线的噪声和长尾数据处理模型

图3为生成的权重曲线的可视化分析。在权重曲线中,干净样本和尾部被赋予较高的权重,而噪声样本和头部样本被赋予较低的权重。这种重赋权策略可以有效的抑制噪声数据的影响并提升模型对尾部数据的学习能力。

图3各类样本生成权重可视化分析

该项研究为机器视觉领域的噪声和长尾数据处理提供了新的思路,为进一步实用化奠定了理论和技术基础。

第一作者简介:

江慎旺,英国威廉希尔公司博士后。2014年、2020年分别获得北京理工大学学士、博士学位,研究方向为机器学习和计算机视觉。在国际顶级会议AAAI、IEEE等期刊发表学术论文16篇,谷歌学术总引用量98次,第一作者4篇,申请中国发明专利1项。曾获得2021 年 ICCV 第二届反无人机国际挑战赛(The 2nd Anti-UAV Workshop & Challenge)冠军及该 Workshop 的最佳论文,大学生数学竞赛二等奖(北京市)、大学生物理竞赛二等奖(北京市)等荣誉。

通讯作者简介:

李佳男,博士,英国威廉希尔公司预聘助理教授(特别副研究员),新加坡国立大学博士后。研究方向为光电成像探测与识别、计算机视觉、嵌入式视频处理等。近五年发表高水平学术论文30篇,其中第一作者论文包括 IEEE TPAMI、TVCG、CVPR、ICLR等顶级期刊会议9篇,ESI高被引论文1篇。论文单篇最高被引600余次,谷歌学术总引用2400余次。主持国自然青年科学基金项目、博士后科学基金一等面上项目和项3项;参与国家自然科学基金重大科研仪器研制项目等5项。入选北京市科协青年人才托举工程,曾获得中国图象图形学学会优秀博士学位论文、王大珩高校学生光学奖等荣誉,获得ImageNet大规模视觉识别挑战赛(ILSVRC-2017)目标定位任务冠军。指导团队获得ICCV 2021“无人机跟踪”挑战赛冠军及最佳论文奖。

许廷发,博士,教授,博导,国家一级重点学科“光学工程”学科责任教授,光电成像技术与系统教育部重点实验室副主任。北京理工大学重庆创新中心智能化和大数据技术实验室主任。近年来带领其科研团队围绕光电成像探测与识别、计算成像和医学光电成像等方向不断深化研究。主持承担国家自然科学基金委重大科研仪器研制项目等40余项。在国际、国内等系列期刊发表学术论文135篇,其中被SCI/EI收录90余篇。以第一发明人申请国家发明专利45项,已授权和公示15项。获国防科技进步二等奖等奖项3项。指导研究生获得中国图象图形学学会优秀博士学位论文,二人次获得王大珩高校学生光学奖,二人次获得全国光学与光学工程博士生学术联赛全国百强等荣誉称号。

论文详情:Jiang, Shenwang, et al. "Delving into Sample Loss Curve to Embrace Noisy and Imbalanced Data." Proceedings of the AAAI Conference on Artificial Intelligence. Vol. 36. No. 6. 2022.

论文链接:https://ojs.aaai.org/index.php/AAAI/article/view/20661